Автор: Product Owner Beinf.ai by Colobridge, Мария Цвыд

Мультимодальный ИИ — это вид искусственного интеллекта, который объединяет и обрабатывает различные типы данных (текст, аудио, видео, изображения) в едином семантическом пространстве, имитируя человеческую способность воспринимать мир комплексно, а не фрагментарно.

- Что такое мультимодальный ИИ и как он работает

- Преимущества мультимодального ИИ

- Инструменты мультимодального ИИ

- Практическое применение технологии

- Проблемы и вызовы

- Будущее мультимодального ИИ

- Самое важное о мультимодальном ИИ

Мультимодальность стала результатом эволюции больших языковых моделей (Large Language Models, LLM), но в отличие от них, позволяет анализировать неструктурированные данные нескольких типов, находя между ними глубокие, неочевидные взаимосвязи.

В ритейле мультимодальная ИИ-система изучает фотографии товаров, описания и отзывы покупателей. Модель распознает, какие фасоны, цвета и сочетания реально носят, а не просто ищут люди, и этой основе делает подборки «товары, которые подойдут для этого образа» и предлагает новые идеи для коллекций. Маркетинг получает готовые инсайты по трендам, а покупатель — более точные рекомендации, которые опираются не только на текст, но и на живой визуальный контент.

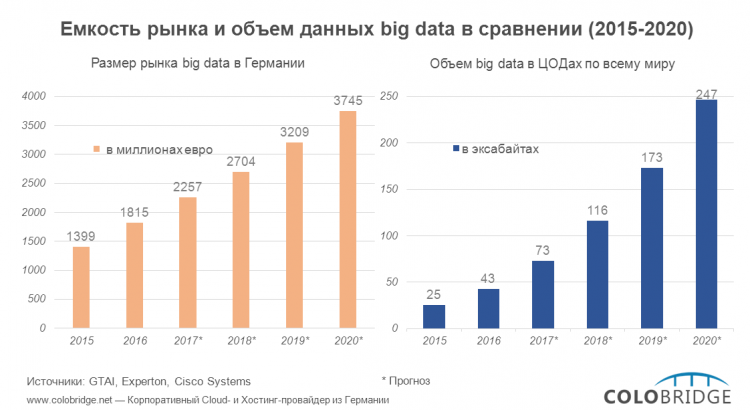

В свое время мультимодальный подход обеспечил огромный скачок в возможностях ChatGPT — c модели GPT 3.2, которая обучалась только на текстовых данных, до GPT 4, обученной на мультимодальных данных (текст и изображения). Сегодня мультимодальный ИИ разрабатывают все основные конкуренты OpenAI, а рынок данной технологии, по данным Precedence Research, вырастет с $2,51 млрд в 2025 до $42,38 млрд до 2034-го. В Европе рынок мультимодального ИИ растет еще динамичнее — с прогнозируемым CAGR около около 32% до 2030 года, при этом ведущим игроком в регионе остается Германия.

Что такое мультимодальный ИИ и как он работает

Модальность в этом термине — это как попытка воспроизвести человеческое восприятие, где зрение и слух работают как единый механизм, а не как отдельные функции. Мультимодальный ИИ действует аналогично: не просто переключается между анализом картинки и текста, а объединяет их в единое смысловое пространство. Это позволяет улавливать контекст, который теряется при раздельной обработке — например, распознавать иронию в голосе и сопоставлять ее с выражением лица на видео.

Как работает мультимодальный ИИ

Поглощение и перевод. ИИ-модель собирает данные из всех доступных каналов: видео с камеры, аудиозапись звонка, текст инструкции или лог-файл сервера. Затем специальные нейросети-энкодеры переводят эти данные в математические векторы. Для модели и фотография яблока, и слово «яблоко», и звук хруста при укусе превращаются в наборы цифр.

Слияние смыслов. Этап слияния данных, или Data Fusion, когда ИИ-модель помещает все векторы в общее многомерное пространство. Здесь система понимает, что звук скрежета на видео (аудио) совпадает с моментом поломки станка (визуальный компонент) и соответствует описанию критической ошибки в инструкции (текст).

Генерация решения. Модель может сгенерировать ответ в любом формате: описать решение текстом, создать новое изображение (рисунок, диаграмму и т. п.) или озвучить инструкцию. Например, ИТ-специалист загружает в интерфейс мультимодального ИИ-ассистента видео, где его программный код выдает ошибку, и одновременно голосом объясняет суть задачи. Система изучает видео, слушает комментарии, анализирует код и выдает исправленный вариант. Она поняла задачу не потому, что вы ее идеально описали текстом, а потому что она восприняла проблему целиком.

Преимущества мультимодального ИИ

Переход от текстовых нейросетей к мультимодальным системам дает бизнесу качественный скачок в точности решений и глубине понимания контекста, что недоступно для классических алгоритмов.

- Целостное восприятие данных. Мультимодальная обработка предполагает работу не с разрозненными файлами, а поиск скрытых взаимосвязей между текстом, звуком и видео, формируя единую картину события.

- Снижение галлюцинаций. Благодаря перекрестной проверке информации из разных источников мультимодальные модели реже выдумывают факты.

- Естественное взаимодействие. Пользователи могут общаться с системой так же, как с другим человеком — показывать пальцем на объект, рисовать эскизы или задавать вопросы голосом прямо во время видеосъемки, не тратя время на написание сложных текстовых промптов.

- Гиперперсонализация. Анализируя визуальные предпочтения и эмоциональные реакции (через голос или мимику) наравне с историей покупок, ИИ создает рекомендации, которые действительно резонируют с вкусом конкретного пользователя.

- Автоматизация сложных задач. Технология берет на себя многоступенчатые процессы, которые раньше требовали исключительно человеческого участия.

Инструменты мультимодального ИИ

Рынок мультимодального ИИ разделили между собой несколько компаний. Гонка технологий вышла за рамки простого увеличения параметров моделей — ключевыми факторами успеха стали специализация, скорость обработки данных и глубина интеграции в бизнес-процессы.

Google — лидер в сегменте мультимодального ИИ. У компании большой опыт построения экосистем, поэтому ее флагманская линейка моделей Gemini 2.5 (Pro и Flash) изначально обучалась на мультимодальных данных. Ее уникальной особенностью стала глубокая интеграция в Vertex AI, когда ИИ-модели не просто работают с готовыми записями видео, но и анализируют их в режиме реального времени. Можно подключить камеру дрона или станка, и нейросеть будет на лету замечать опасности или брак, не дожидаясь, пока видео загрузится на сервер.

В OpenAI сделали ставку на GPT-5, где фокус с простого чат-бота сместился в сторону проактивного агента. Здесь мультимодальная модель понимает интонацию, перебивания, вздохи и в результате отвечает не машинным, а эмоционально окрашенным текстом. Это может трансформировать работу традиционных IVR-систем в колл-центрах, заменив их эмпатичных цифровых операторов. Также в GPT-5 появилась способность к размышлениям перед ответом, что критически важно для мультимодальных задач.

Anthropic и ее Claude 3.5 Opus стали эталоном в задачах, требующих сложного кодинга и работы с длинными документами. Мультимодальность этой модели заточена на анализ чертежей, схем и рукописных заметок.

Meta со своей моделью Llama 4 весной 2025 года впервые предложила раннее слияние (early fusion) текста и изображений в открытом доступе. Эта мультимодальная модель понимает визуальный контент так же глубоко, как и решения от конкурентов, но делает это бесплатно за счет Open Source.

Французский стартап Mistral также пошел по пути использования открытых моделей и предоставил линейку компактных мультимодальных ИИ-моделей Ministral 3. Они работают даже на ноутбуках или роботизированных устройствах без доступа к интернету.

Преимущества популярных мультимодальных ИИ-моделей собраны в таблице:

| Gemini 2.5 (Pro/Flash) | OpenAI GPT-5 | Claude 3.5 Opus | Llama 4 | Ministral 3 |

|---|---|---|---|---|

| Нативная мультимодальность Анализ видео в реальном времени без задержек Интеграция с корпоративными сервисами Google | Эмпатичный голос Функции ИИ-агента Способность размышлять и планировать действия на крок вперед | Инженерная точность Скрупулезная работа с документами Безопасность и строгие этические фильтры | Open Source-решение Понимание изображений на уровне архитектуры. Развертывание на сервере клиента | Компактность Полная автономность (локальная работа) Гибкая настройка модульности под конкретную задачу |

| Контекстное окно — до 2 млн токенов (лучший вариант для «тяжелых» данных и видеоанализа) | Контекстное окно — 400 тыс. токенов, нативная поддержка аудио и видео (идеально для ИИ-агентов) | Контекстное окно — 200 тыс. токенов (оптимально для написания кода и текстов) | Контекстное окно — 10 млн токенов, iRoPE для «бесконечного» контекста (анализ огромных массивов данных) | Контекстное окно — 128 тыс. токенов, доступна локальная установка (Private Cloud/On-premise) |

Практическое применение технологии

Мультимодальный ИИ перестал быть экспериментом и превратился в рабочий инструмент, который уже меняет процессы в ключевых секторах экономики.

Здравоохранение

Врачи могут больше не изучать диагностические снимки и анализы по отдельности — мультимодальные модели собирают воедино данные МРТ, записи в электронной карте и показатели с умных часов пациента. Анализируя эти данные, ИИ выявляет скрытые признаки болезней и помогает создать точный план лечения.

Промышленность и производство

Здесь технология стала стандартом для визуального контроля качества. Камеры на конвейерах в реальном времени транслируют видео в модель, которая сопоставляет изображение детали с ее чертежами, мгновенно отбраковывая изделия с микродефектами. Это снижает процент брака эффективнее, чем привлечение живых операторов.

Ритейл и e-commerce

Мультимодальность стирает границу между «увидеть» и «купить». Пользователи ищут товары, загружая фото понравившегося образа, а умные примерочные подсказывают размер и фасон, анализируя видео с камеры смартфона и сопоставляя его с лекалами одежды. А магазины анализируют видеопотоки в торговых залах для оптимизации выкладки товаров — такие кейсы в ритейле не редкость.

Автомобилестроение и БПЛА

Для автопилота мало просто видеть дорогу перед собой, он должен понимать контекст. Мультимодальные модели объединяют данные с камер и GPS, обогащают их звуками с улицы (гудки, сирены, сигналы светофора), чтобы принимать решения за доли секунды. Это повышает безопасность движения в непредсказуемых городских условиях.

Финансы и страхование

Страховщики используют технологию для быстрой оценки ущерба: клиент загружает видео поврежденного имущества, а ИИ сверяет его с полисом и историей объекта. В банкинге мультимодальная биометрия (голос + лицо + поведение) может стать новым стандартом защиты от мошенничества, сокращая риски взлома аккаунта.

Кто и как уже использует мультимодальный ИИ? Например, в Waymo разработали мультимодальную ИИ-модель для автономного вождения EMMA на базе Gemini — она легко ориентируется в плотном городском потоке и распознает даже самые сложные сценарии. Virtual Volunteer, он же «виртуальный волонтер» от Be My Eyes, работает на базе на базе GPT-4 и генерирует для слабовидящих людей описания окружающего мира на основе изображений и текста (например, при покупке товаров в супермаркете). А немецкая платформа Zalando внедрила мультимодального ассистента, который, в отличие от старых чат-ботов, понимает сложные запросы. Можно загрузить фото обуви и спросить, какая сумка подойдет к ней с учетом погоды и модных трендов.

Chief Operating Officer Colobridge, Андрей Михайленко:

«Вариантов использования мультимодального ИИ намного больше, чем может вместить эта статья. На базе этой технологии можно создавать инструменты для модерации контента, мультимодальные креативные приложения, организовывать умный поиск в любых каталогах и многое другое. Эти решения уже перешли от экспериментальных к практическим, поэтому в ближайшее время нас ждет еще больше интересных кейсов, в которых будет задействован мультимодальный ИИ».

Проблемы и вызовы

Основные барьеры, которые мешают внедрению мультимодального ИИ — это повышенные требования к вычислительным мощностям и сложность отладки процесса выдачи результатов из-за слияния разнородных потоков данных. Основные мощности идут не на процесс обучения модели, а на инференс — процесс применения уже обученной модели искусственного интеллекта в конкретных задачах. Для синхронной обработки, текста, видео и голоса и голоса требуются высокопроизводительные GPU-кластеры с минимальной задержкой, что делает архитектуру частного облака наиболее подходящим решением для Enterprise-сегмента.

Также вызывают тревогу риски конфиденциальности и кибербезопасности, так как работа с голосом и видео открывает возможность для неконтролируемого создания реалистичных дипфейков. Плюс инженерам приходится бороться с «каскадной» предвзятостью, когда скрытые стереотипы в одной модальности усиливаются другими.

Будущее мультимодального ИИ

Мультимодальный ИИ стали настоящим прорывом на фоне того, как выросли ожидания пользователей за последние два-три года. Решения на базе этой технологии становятся более автономными, ориентированными на активные действия и принятие решений. Появились ИИ-агенты с «мультимодальным мышлением», которые самостоятельно разрабатывают планы для достижения сложных целей, комбинируют видео и аудио из разных источников видеопотоки, голосовые команды и текстовые инструкции. Это значит, что мультимодальный ИИ будущего будет еще более гибким, сможет мгновенно переходить от распознавания голоса к анализу изображения и, вероятно, станет ключевым в создании умных роботов-помощников.

На первый взгляд мультимодальные ИИ-модели становятся более сложными, но это не мешает тренду на миниатюризацию. Наиболее интересными сегодня выглядят легковесные разработки, которые могут работать на пользовательских устройствах и в IoT-средах без связи с облаком. Это открывает путь к появлению действительно приватных ассистентов и гиперперсонализированных поисковых систем — они формируют выдачу, учитывая не только слова запроса, но и визуальные подсказки и поведение конкретного пользователя.

Самое важное о мультимодальном ИИ

- В основе мультимодального ИИ лежит принцип человеческого восприятия, объединяя данные из разных источников в единое смысловое пространство.

- Техногиганты вроде Google (Gemini), OpenAI (GPT-5) и Anthropic (Claude) уже предлагают свои мультимодальные модели.

- Разработка требует больших вычислительных ресурсов и создает новые вызовы в области безопасности данных.

- Технология применяется в медицине, на производстве, в ритейле, робототехнике.

- Будущее — за автономными ИИ-агентами и компактными моделями для работы на локальных устройствах.

Узнайте, как облачные технологии, передовые инструменты в области защиты данных и искусственного интеллекта могут изменить ваш бизнес — напишите нам, чтобы согласовать встречу с менеджером Colobridge.